Khả năng phản hồi của GPT-4o vừa được cải thiện đáng kinh ngạc sau khi ra mắt, điều này khiến cho việc xem xét liệu ChatGPT có thể được coi là vị vua của các mô hình ngôn ngữ hay không.

Khi mới xuất hiện, Gemini của Google thường được so sánh với ChatGPT về tốc độ và được nhấn mạnh rằng nó mạnh gấp 5 lần và nhanh hơn nhiều so với GPT-4, trong khi tiêu thụ ít tài nguyên GPU hơn.

Có vẻ như OpenAI không hài lòng với điều này, vì chatbot GPT-4o mới ra mắt đã có tốc độ phản hồi cao hơn nhiều so với GPT-4, khiến cho GPT-4 trở nên lỗi thời khi so sánh.

Tốc độ nhanh gấp 2 lần GPT-4 Turbo

Trong thực tế, GPT-4 đã đạt được mức độ hoàn thiện đủ để đáp ứng nhu cầu của nhiều người dùng, tuy nhiên điểm yếu lớn nhất của nó là tốc độ phản hồi chậm hơn so với các mô hình ngôn ngữ khác như Gemini của Google hay Claude 3 từ Anthropic. Những mô hình này vượt trội ChatGPT về tốc độ và chất lượng câu trả lời. Mặc dù vậy, GPT-4 vẫn có những ưu điểm khác giúp duy trì sự quan tâm của người dùng, tuy nhiên tốc độ, chất lượng câu trả lời và ngôn ngữ hỗ trợ vẫn là những yếu tố hạn chế của mô hình này.

GPT-4o ra đời như một bước tiến mới. Trong bản demo, GPT-4o đã tạo ra một câu trả lời dài 488 từ chỉ trong khoảng chưa đầy 12 giây. Một công việc tương tự có thể mất gần một phút nếu sử dụng GPT-4 thông thường. Điều này cho thấy sự cải thiện đáng kể mà GPT-4o mang lại về tốc độ phản hồi. Sự nhanh chóng của nó khiến nhiều người tự hỏi liệu ChatGPT có phải là mô hình ngôn ngữ hàng đầu hay không, XDA nhận định.

Trong một video khác, việc tạo một tệp tin CSV chứa thông tin về 50 thành phố lớn nhất thế giới chỉ mất GPT-4o chưa đầy một phút, trong khi GPT-4 thì mất rất nhiều thời gian để hoàn thành công việc tương tự. Giám đốc công nghệ của OpenAI, Mira Murati, cho biết rằng GPT-4o nhanh hơn rất nhiều so với phiên bản trước đó và đã được cải thiện về khả năng xử lý văn bản, video và âm thanh. Với tính ứng dụng và tiện ích cao, đây thực sự là một bước tiến quan trọng.

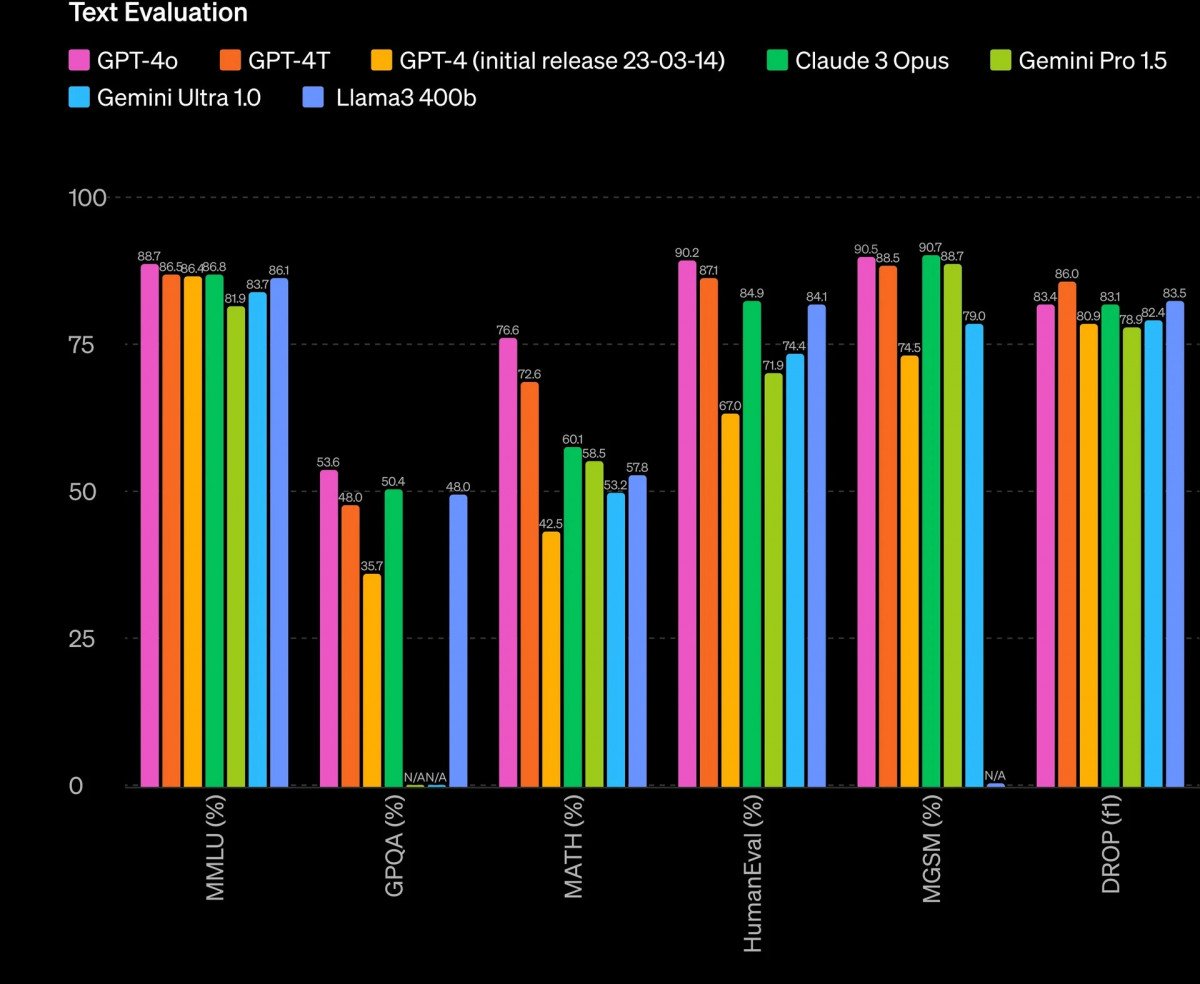

Nếu vấn đề chính với GPT-4 của bạn là tốc độ, thì không cần phải lo lắng nữa. GPT-4o nhanh hơn đáng kể so với GPT-4 thông thường, thậm chí còn nhanh hơn gấp đôi so với GPT-4 Turbo. Hơn nữa, mô hình này cũng rẻ hơn 50% cho các nhà phát triển muốn triển khai và có khả năng xử lý với tốc độ cao hơn nhiều. GPT-4o cũng được cải thiện về khả năng suy luận so với GPT-4 Turbo.

Dịch đồng thời sang hai ngôn ngữ ngay lập tức

GPT-4 Omni (viết tắt là GPT-4o) đã được OpenAI giới thiệu vào ngày 13/5 dưới tên “bản cập nhật mùa xuân”. Bên cạnh việc cải thiện tốc độ và miễn phí hóa cho nhiều người sử dụng phiên bản ChatGPT này, GPT-4o mở rộng khả năng tương tác của người dùng thông qua ứng dụng trên điện thoại thông minh hoặc máy tính cá nhân một cách tự nhiên như cuộc trò chuyện.

Phiên bản mới của ChatGPT đi kèm với trợ lý giọng nói có khả năng cạnh tranh với Alexa của Amazon. Chatbot này có khả năng giao tiếp tự nhiên đến mức có thể mô phỏng các đặc điểm của con người như việc ngắt lời, hiểu biết về tông giọng và thậm chí là việc mắc lỗi một cách cố ý.

Trong một bản demo trực tiếp, MC đã yêu cầu GPT-4o phản hồi về kỹ thuật thở của mình. Anh ta thở dốc vào điện thoại, khiến ChatGPT trả lời một cách hóm hỉnh: “Tôi không phải là máy hút bụi”, sau đó đưa ra lời khuyên là học cách thở chậm hơn. Điều này thể hiện khả năng lắng nghe, hiểu biết và phản ứng với các cảm xúc của con người.

GPT-4o cũng có khả năng đáp trả các bình luận giống như con người. Ví dụ, khi được khen ngợi là hữu ích và xuất sắc, nó trả lời: “Ồ, dừng lại đi, bạn làm tôi đỏ mặt”.

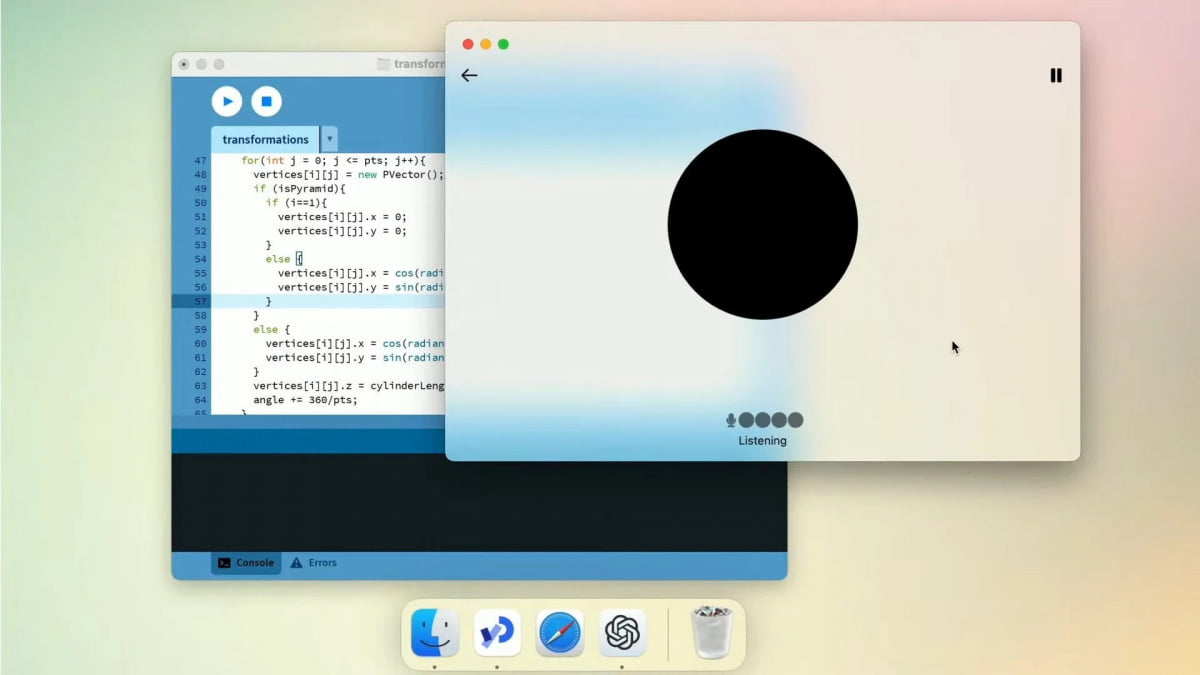

Ngoài khả năng hài hước, chatbot mới còn có thể thay đổi giọng điệu của câu trả lời, thêm cử chỉ và biểu cảm trong quá trình truyền đạt suy nghĩ bằng lời nói. Tương tự như cuộc trò chuyện giữa con người, bạn có thể ngắt giọng của trợ lý AI và chỉnh sửa nó, thay đổi nội dung hoặc ngừng nói. Bạn cũng có thể yêu cầu nó nói bằng giọng khác hoặc giọng robot, cung cấp bản dịch kèm theo.

Trong một bản demo khác, hai người thuyết trình trên sân khấu – một người nói tiếng Anh và một người nói tiếng Italy – đã trò chuyện với GPT-4o. Nó có khả năng cung cấp bản dịch từ tiếng Italy sang tiếng Anh và ngược lại một cách nhanh chóng và liền mạch.

AI có khả năng hiểu và thể hiện cảm xúc giống như con người

Ngoài ra, GPT-4o không chỉ có khả năng hiểu và phản ứng với giọng nói của con người mà còn có khả năng nhận diện và hiểu hình ảnh. Ví dụ, chatbot có thể nhìn vào một bức ảnh selfie và tạo ra mô tả về trang phục hoặc cảm xúc của người trong bức ảnh.

Theo OpenAI, GPT-4o khác biệt so với các phiên bản trước đó bởi người dùng có thể gián đoạn mô hình AI khi đang nói và yêu cầu nó trả lời ngay lập tức, giảm độ trễ xuống chỉ 2-3 giây.

ChatGPT hiện đã có khả năng nhận diện cảm xúc thông qua việc nhìn vào khuôn mặt qua camera. Trong bản demo, AI đã nhận ra khuôn mặt tươi cười của đại diện OpenAI và hỏi: “Bạn muốn chia sẻ điều gì đã làm bạn cảm thấy vui vẻ như vậy không?”

Không chỉ nhận diện cảm xúc, GPT-4o còn có khả năng tạo ra cảm xúc. Trong một trường hợp, nhân viên OpenAI đã yêu cầu trợ lý AI đọc một câu chuyện trước khi đi ngủ với biểu cảm đa dạng và kịch tính hơn. Kết quả là, GPT-4o đọc với giọng hùng hồ hơn và có thể chuyển sang giọng nói robot theo yêu cầu. Người dùng cũng có thể yêu cầu nó hát và thấy sự thay đổi ngay lập tức.

Trong quá trình sử dụng thử nghiệm, ChatGPT hoạt động một cách nhanh chóng và không gặp khó khăn trong việc nghe, hiểu và trả lời câu hỏi từ người dùng. GPT-4o cũng tự nhiên hơn khi nhập truy vấn, cho phép người dùng nói chuyện với điện thoại của mình và nhận được phản hồi linh hoạt – không phải là câu trả lời kiểu mẫu như “Hãy tự tra Google đi”.

Một cập nhật quan trọng khác là mô hình AI của OpenAI được tích hợp vào Giao diện lập trình ứng dụng trí tuệ nhân tạo (API). Điều này giúp các nhà phát triển bắt đầu xây dựng mô hình của riêng mình với chi phí giảm 50% và tốc độ nhanh hơn gấp đôi. ChatGPT-4o cũng hỗ trợ 50 ngôn ngữ và 97% dân số thế giới.Theo đánh giá từ Toms Guide, điều này chỉ là một cái nhìn tổng quan về khả năng của ChatGPT-4. Tuy nhiên, đã rõ ràng rằng nó đã có những tiến bộ thông minh và linh hoạt hơn so với Siri, Google Assistant/Gemini và Alexa. Với tin đồn về việc Apple đang phát triển Siri 2.0 và sự kiện Google I/O sắp diễn ra vào ngày mai, cuộc đua trong lĩnh vực trí tuệ nhân tạo đang trở nên gay gắt hơn.